Znáte OpenAlt konferenci? Před cca 10 lety se těmto konferencím říkalo LinuxAlt, později se přejmenovali na OpenAlt. Jedná se o konferenci, kde uvidíte přednášky o všem, co je open-source. Domnívám se, že bych nikdy nesepsal tak kvalitní úvod do teorie neuronových sítí, strojového učení a umělé inteligence, proto sem vkládám následující video. Moc zdravím Václava Knappa, komunitu návštěvníků kolem OpenAltu a sdílím jak odkaz na OpenAlt, který bych tu rád zapropagoval a přikládám fakt pěknou přednášku na téma: Historie a současnost výzkumu umělé inteligence.

Je to vhodné pro začátečníky, úvod např. pro management, aby měl základní pochopení problematiky, pro vás ostatní se budu v dalších dílech věnovat tvorbě vlastního modelu nad ChatGPT a domnívám se, že jsem tu historicky vložil již jeden pilotní díl o tom, jak používat různé AI produkty.

Proč?

Domnívám se, že AI nutně jakožto lidstvo potřebujeme k řešení netriviálních problémů, jejichž doba řešení s množstvím řešených problémů, převyšuje schopnosti člověka zpracovat např. větší množství dat/vyřešených problémů v krátkém čase. V budoucnu bude ubývat i pracovní síly, kvůli nízké porodnosti, takže používání AI má v budoucnu potenciál k navýšení produktivity práce za zaměstnance odcházející z trhu práce do důchodu.

Sylabus přednášky

- Povědomí o umělé inteligenci ve společnosti

- ELIZA (1966)

- DeepBlue vs. Gary Kasparov (1997)

- AlphaGo (2017)

- Technický vývoj

- První algoritmus Ada Lovelace (1840)

- Skupina 10 vědců na 6 týdenním symposiu vymýšlí nový pojem „Umělá inteligence“ (1956)

- První větší neuronová síť s fyzickým propojením dráty cca 20 000 spojení pro rozpoznávání lidí, koček, psů na obrázku pro armádní výzkum (1958)

- AI Winter – AI ZIMA, zastavený vývoj kvůli absenci financování, Moravcův Paradox: „Počítač může jednoduše spočítat jakoukoliv matematickou rovnici, ale nezvládne vyklidit pračku“ (1973 – 1980)

- Nvidia Cuda (2006)

- Knihovny na programování neuronových sítí Tensorflow & Pytorch (2011)

- Současné technologie

- Deep Learning -> Machine Learning -> Artificial Intelligence

- Co tvoří základ neuronové sítě (neuron)

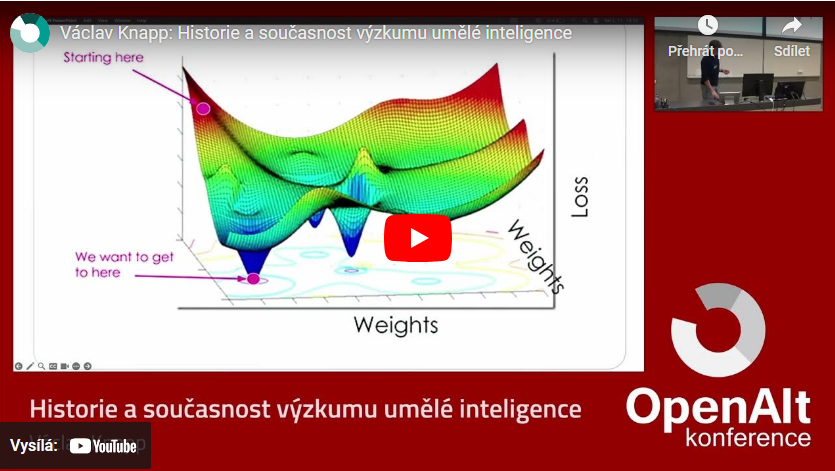

- Měnění váh (weights)

- Architektura Transformers (na tom se zakládá dnešní ChatGPT, rozpoznávání obrazu, původně vyvinutá pro google překladač)

- 3 principy:

- Poziční kódování (Positional encoding) „mám rád psy“ slova se převedou na čísla 1, 2, 3.

- Attention (naučíme model, jak jdou slova za sebou),

- Self attention (sebe-pozornost) nám dovoluje rozumět textům v ohledu mezi větama, aby jazykový model pochopil kontext.

- Počítačové vidění (Computer vision)

- Algoritmus konvoluce (z obrázků zmenšuje velikost obrázků na menší a menší jednotky, aby se s tím dalo lépe používat) => Použití ve zdravotnictví – rozpoznávání snímků z rentgenu, detekce mozkových nádorů v magnetické rezonanci, NASA používá pro rozpoznávání překážek na Marsu, použití pro samořízení atd…

- Nejnovější výzkum a organizace, které se mu věnují:

- MIT (CSAIL), UC Berkeley (BAIR), Stanford (Stanford AI) <- cutting edge research

- BAIR – Jitendra Malik lab, Alexei efros lab

- MIT – Daniela Rus lab

- Stanford – Fei-Fei Li Lab (jeden ze zakladatelů oboru)

- Inteligentní systémy pro zpracování obrazu

- CLIP – základ multimodálních systémů (model, třeba chatGPT dneska umí zpracovat obrázky, či text. Může to být zvuk, video, text, obrázek, co lze převést na vektor, na nějakou matematickou operaci). OpenAI vyšel CLIP před cca 6 lety a umí to dávat do kontextu s obrázky i s textem.

- Phalp – rozpoznávání lidí v obrazu. Snaha předpovědět pohyb člověka v obrazu.

- Dreamsim – tvorba syntetických dat pro kontrastní učení.

- Kontrastní učení aneb cesta k inteligentním systémům (rozpoznávání třetího rozměru v obrázcích). Zatím jen 50% úspěšnost. Snaží se model vylepšit na úroveň člověka, tedy nad 80%. Řeší se, kde je chyba, jestli je chyba v architektuře, v datasetu, nebo v samotném stylu učení.

- Samořízení – automatické řízení vozidel. Rozpoznávání objektů na silnici v reálném čase. (ukázka videa z Tesla vozů). Tesla nepoužívá lidar, ale rozpoznávání obrazu. Lidar je dražší, než rozpoznávat obraz (z dlouhodobého hlediska).

- AlphaFold – nobelova cena za Chemii. Model, který z jednoduchého řádku aminokyselin dokážeme předpovědět 3d strukturu aminokyselin a jednalo se o 100 let nevyřešený problém. Vyřešit jednu takovou strukturu trvalo cca 1 rok. Nyní se díky tomu zrychlil výzkum léků a vakcín.

- Nobelovy ceny 2024:

- Fyzika Geoffrey Hinton (za rozvoj AI),

- Fyzika John Hopfield (za rozvoj AI)

- Chemie Demis Hassabis (model AlphaFold2 Google DeepMind)

- Chemie John M. Jumper (model AlphaFold2 Google DeepMind )

- Chemie David Baker (Watchingtonská univerzita – počítačový návrh proteinů)

Dotazy:

Co autor prezentoval před týdnem v USA?

Výuka lidí znakového jazyka pomocí počítačového vidění

Je posun ve vývoji AI z hlediska zjednodušení výpočtů a zefektivnění AI aby nedocházelo k tak vysoké spotřebě energie?

Ano, část komunity vyvíjí, jak zjednodušit výpočty. Váhy mohou mít až 110 desetinných míst. To je výpočetně velmi náročně a část komunity se snaží najít hranici, kde dojde např. k ušetření 50 desetinných míst, tedy poloviny času na výpočet bez ztráty výsledné kvality. A potom část komunity řeší, jak jsou stavěné architektury. Cca 15 – 20% komunity řeší, jak jsou modely výpočetně náročné.

Zdroje jsou uvedeny v článku v odkazech. Očekávám, že v příštích dílech vám ukážu, jak si postavit vlastní model nad ChatGPT, který následně můžete někde použít.